Dowiedz się, dlaczego tradycyjne metody web scraping oparte na regex zawodzą przy analizie PDF i jak AI rozwiązuje problem parsowania niestrukturalnych danych.

Jeśli kiedykolwiek próbowałeś zautomatyzować ekstrakcję danych z dokumentów PDF, na pewno znasz ten moment frustracji: twój starannie napisany scraper, który działał perfekcyjnie przez miesiące, nagle przestaje działać po minimalnej zmianie layoutu dokumentu. To klasyczny przykład długu technologicznego, który gromadzi się w projektach opartych na tradycyjnych metodach parsowania. W tym kompleksowym przewodniku przeanalizujemy, dlaczego regex nie działa na PDF w sposób niezawodny i przedstawimy nowoczesne rozwiązania oparte na sztucznej inteligencji.

Dlaczego tradycyjny web scraping zawodzi przy dokumentach PDF?

Wielu programistów zaczyna swoją przygodę z automatyzacją od narzędzi takich jak Python BeautifulSoup, które świetnie sprawdzają się przy strukturyzowanych danych HTML. Problem pojawia się, gdy te same metody próbujemy zastosować do dokumentów PDF, które mają zupełnie inną naturę. Podczas gdy HTML ma względnie przewidywalną strukturę drzewa DOM, PDF to właściwie instrukcje rysowania dla drukarki - zestaw absolutnie pozycjonowanych elementów bez semantycznej struktury.

Podstawowy problem: PDF to nie HTML

Kluczowe wyzwanie w parsowaniu niestrukturalnych danych z PDF polega na tym, że ten format został zaprojektowany z myślą o wiernym odwzorowaniu wyglądu dokumentu na różnych urządzeniach, a nie o łatwej ekstrakcji treści. Nawet pozornie proste zadanie, jak konwersja PDF to JSON Python, staje się koszmarem, gdy dokument zawiera tabele, kolumny, nagłówki stopek czy grafikę. Każda zmiana czcionki, marginesów lub układu stron wymusza przepisanie reguł ekstrakcji.

Limity wyrażeń regularnych w praktyce

Wyrażenia regularne (regex) mają fundamentalne ograniczenia w kontekście analizy dokumentów:

- Działają tylko na tekst, ignorując kontekst wizualny

- Nie rozumieją relacji przestrzennych między elementami

- Brakuje im zdolności do generalizacji wzorców

- Wymagają ciągłego dostosowywania do nowych formatów

To właśnie te ograniczenia sprawiają, że jak naprawić scraper staje się codziennym zadaniem dla zespołów utrzymaniowych, zamiast strategicznym rozwojem. Więcej o wyzwaniach związanych z automatyzacją przetwarzania dokumentów przeczytasz w naszym wpisie o pełnej automatyzacji dokumentów PDF z API REST.

AI jako alternatywa dla wyrażeń regularnych

Nowa generacja narzędzi do ekstrakcji danych opiera się na zaawansowanych modelach sztucznej inteligencji, które radzą sobie z wyzwaniami niedostępnymi dla tradycyjnych metod. Podczas gdy regex szuka dokładnych wzorców tekstowych, AI rozumie kontekst, strukturę i znaczenie dokumentu. To fundamentalna różnica w podejściu do problemu parsowania niestrukturalnych danych.

Jak działa AI do scrapowania danych?

Nowoczesne systemy AI do scrapowania danych wykorzystują kilka warstw analizy:

- Rozpoznawanie struktury dokumentu - identyfikacja sekcji, nagłówków, tabel, list

- Zrozumienie kontekstu semantycznego - rozróżnianie dat, kwot, nazwisk, adresów

- Ekstrakcja relacji - łączenie powiązanych elementów w logiczne całości

- Adaptacja do zmian - uczenie się nowych formatów bez reprogramowania

Takie podejście sprawia, że systemy oparte na AI, takie jak funkcje analizy dokumentów PARSEMINT, radzą sobie z dokumentami, które całkowicie paraliżują tradycyjne scrapers. Jeśli interesuje Cię, jak to działa w praktyce dla dokumentów finansowych, sprawdź nasz przewodnik o automatycznej ekstrakcji danych finansowych z PDF.

Case study: Realne problemy z regex vs AI

Przykład 1: Analiza faktur w różnych formatach

Rozważmy typowy scenariusz biznesowy: firma otrzymuje faktury od 50 różnych dostawców, każdy z własnym szablonem dokumentu. Przy podejściu regex potrzebujesz:

- 50 różnych zestawów reguł ekstrakcji

- Częste aktualizacje przy zmianie szablonów

- Ręczną weryfikację wyników

- Wysokie koszty utrzymania

System oparty na AI potrzebuje jedynie przykładowych dokumentów do nauki, a następnie sam generalizuje wzorce ekstrakcji. To właśnie rozwiązuje problem dlaczego regex nie działa na PDF w środowiskach o dużej zmienności dokumentów.

Przykład 2: Przetwarzanie dokumentów prawnych

Dokumenty prawne często zawierają skomplikowane tabele, przypisy, odwołania między sekcjami i warunkowe klauzule. Tradycyjny scraper oparty na python beautifulsoup alternatywa dla PDF musi śledzić setki specjalnych przypadków. AI natomiast rozumie logiczną strukturę dokumentu i potrafi ekstrahować klauzule wraz z ich kontekstem, niezależnie od wizualnego układu.

Techniczne aspekty: Od regex do AI w praktyce

Architektura nowoczesnego parsera PDF

Nowoczesne parser pdf api opierają się na architekturze wielowarstwowej:

- Warstwa wizualna - rozpoznawanie układu stron, kolumn, sekcji

- Warstwa semantyczna - klasyfikacja typów treści (nagłówki, treść główna, tabele)

- Warstwa ekstrakcji - identyfikacja i wyodrębnianie konkretnych danych

- Warstwa walidacji - sprawdzanie spójności i kompletności wyników

Takie podejście minimalizuje dług technologiczny, ponieważ każda warstwa może być niezależnie ulepszana i dostosowywana. Jeśli potrzebujesz takiego rozwiązania dla swojej firmy, sprawdź plany subskrypcji PARSEMINT dostosowane do różnych potrzeb.

Integracja z istniejącymi systemami

Jedną z największych obaw przy przejściu z regex na AI jest integracja z istniejącymi pipeline'ami danych. Nowoczesne parser pdf api oferują:

- REST API zgodne z obecnymi standardami

- Formaty wyjściowe takie jak JSON, XML, CSV

- Obsługę webhooków dla asynchronicznego przetwarzania

- Kompatybilność z popularnymi językami programowania

W praktyce oznacza to, że możesz zastąpić swoją obecną implementację regex nowoczesnym API bez przebudowy całego systemu. Więcej o integracji dowiesz się z dokumentacji API PARSEMINT.

Bezpieczeństwo i zgodność w erze AI

Przejście na rozwiązania AI do web scraping dokumentów wrażliwych wymaga szczególnej uwagi dla bezpieczeństwa. W przeciwieństwie do lokalnych skryptów regex, które działają w izolacji, rozwiązania chmurowe muszą spełniać rygorystyczne standardy. Kluczowe aspekty to:

- Szyfrowanie danych w transferze i spoczynku

- Certyfikaty zgodności z RODO i innymi regulacjami

- Izolacja danych między klientami

- Audytowalność operacji

Te kwestie są szczególnie ważne w kontekście dokumentów finansowych, audytowych czy medycznych. Więcej o standardach bezpieczeństwa przeczytasz w naszym artykule o zabezpieczeniach danych w Document AI.

Koszty i ROI: Regex vs AI w dłuższej perspektywie

Ukryte koszty utrzymania scrapers opartych na regex

Wiele firm nie docenia prawdziwego kosztu utrzymania rozwiązań opartych na regex:

- Koszty programistyczne - ciągłe dostosowywanie reguł do nowych formatów

- Koszty operacyjne - ręczna interwencja przy błędach ekstrakcji

- Koszty biznesowe - opóźnienia w przetwarzaniu dokumentów

- Koszty ryzyka - błędy w ekstrakcji krytycznych danych

Te ukryte koszty często przekraczają roczne wydatki na nowoczesne rozwiązania AI, co sprawia, że alternatywa dla wyrażeń regularnych staje się ekonomicznie uzasadniona.

Przykład kalkulacji ROI

Rozważmy firmę przetwarzającą 1000 dokumentów miesięcznie:

- Przy podejściu regex: 20 godzin/miesiąc na utrzymanie × 150 zł/godzina = 3000 zł/miesiąc

- Przy podejściu AI: abonament 499 zł/miesiąc + 5 godzin/miesiąc × 150 zł = 1249 zł/miesiąc

- Oszczędność: 1751 zł miesięcznie (58% redukcji kosztów)

Do tego dochodzi wyższa dokładność ekstrakcji i szybsze przetwarzanie, które dodatkowo zwiększają ROI.

Jak wdrożyć AI do scrapowania danych w swojej organizacji?

Krok po kroku: Migracja z regex na AI

Jeśli zastanawiasz się, jak naprawić scraper na stałe, oto praktyczny plan migracji:

- Audyt obecnych rozwiązań - zidentyfikuj najbardziej problematyczne dokumenty

- Testowanie proof-of-concept - przetestuj AI na reprezentatywnych dokumentach

- Integracja fazowa - zacznij od najbardziej krytycznych dokumentów

- Równoległe działanie - uruchom nowy i stary system równolegle

- Pełne przejście - wyłącz stare rozwiązania po udanej walidacji

Takie podejście minimalizuje ryzyko i pozwala na płynne przejście bez zakłóceń w operacjach biznesowych.

Wybór odpowiedniego narzędzia

Przy wyborze parser pdf api zwróć uwagę na:

- Obsługiwane formaty dokumentów

- Dokładność ekstrakcji dla Twoich typów dokumentów

- Czasy odpowiedzi API

- Możliwości integracji

- Zgodność z wymaganiami bezpieczeństwa

- Elastyczność planów cenowych

Platforma PARSEMINT oferuje wszystkie te funkcje, dostosowując się do potrzeb małych firm i dużych przedsiębiorstw.

Przyszłość ekstrakcji danych: Poza regex i AI

Rozwój technologii przetwarzania dokumentów nie kończy się na obecnych rozwiązaniach AI. Nadchodzące trendy to:

- Multimodalne modele AI - łączące analizę tekstu, obrazów i układu

- Uczenie ciągłe - systemy, które stale poprawiają się na nowych danych

- Ekstrakcja kontekstowa - rozumienie dokumentów w szerszym kontekście biznesowym

- Automatyczna walidacja - systemy sprawdzające spójność ekstrahowanych danych

Te rozwinięcia sprawią, że problem dlaczego regex nie działa na PDF stanie się przeszłością, podobnie jak ręczne wprowadzanie danych z dokumentów papierowych.

Podsumowanie: Dlaczego warto przejść z regex na AI już teraz?

Debata regex vs ai w kontekście ekstrakcji danych z PDF została praktycznie rozstrzygnięta. Podczas gdy regex nadaje się do prostych, stabilnych wzorców w kontrolowanym środowisku, AI oferuje:

- Odporność na zmiany layoutu - system uczy się struktury, nie sztywnych wzorców

- Wyższą dokładność - rozumienie kontekstu redukuje błędy

- Niższe koszty utrzymania - eliminacja ciągłego dostosowywania reguł

- Skalowalność - obsługa tysięcy formatów dokumentów

- Przyszłościowość - gotowość na ewolucję formatów dokumentów

Jeśli zmagasz się z problemami web scraping dokumentów PDF i szukasz alternatywy dla wyrażeń regularnych, nadszedł czas na zmianę paradygmatu. Rozwiązania oparte na AI, takie jak nasza platforma, oferują nie tylko natychmiastową ulgę od problemów z scrapers, ale także strategiczną przewagę w erze cyfrowej transformacji.

Gotowy na rewolucję w przetwarzaniu dokumentów? Sprawdź plany PARSEMINT i odkryj, jak AI może uwolnić Twój zespół od koszmaru ciągłego naprawiania scrapers. Zacznij od darmowego planu, przetestuj na swoich dokumentach i przekonaj się, dlaczego setki firm już porzuciły regex na rzecz inteligentnej ekstrakcji danych.

Wypróbuj PARSEMINT już dziś!

Rozpocznij analizę dokumentów PDF z pomocą sztucznej inteligencji. Bezpłatny plan dostępny od razu.

Powiązane wpisy

Archiwum "Przed KSeF": Jak zdigitalizować segregatory z lat 2020-2025 w jeden weekend?

Praktyczny przewodnik po masowej cyfryzacji archiwum dokumentów sprzed KSeF. Dowiedz się, jak przenieść stare faktury do chmury i stworzyć przeszukiwalne PDF w 48 godzin.

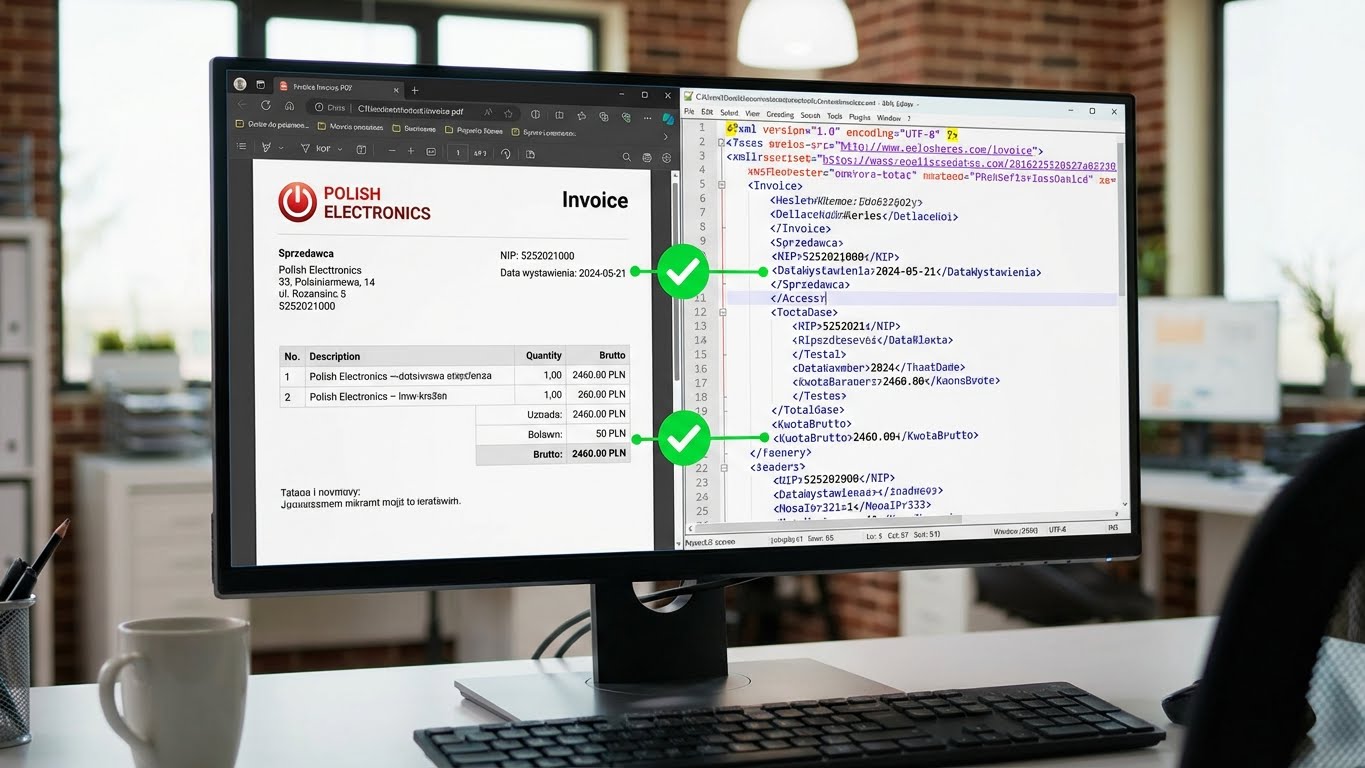

Walidacja KSeF: Jak automatycznie sprawdzić zgodność PDF (Wizualizacja) z XML?

Poznaj metody automatycznej weryfikacji faktur KSeF. Dowiedz się, jak sprawdzić zgodność PDF z XML i uniknąć błędów księgowych dzięki inteligentnej analizie dokumentów.

Dziura w KSeF: Paragony, Taksówki i Delegacje. Jak domknąć cyfryzację wydatków pracowniczych?

Poznaj praktyczne rozwiązania na domknięcie obiegu dokumentów w KSeF. Dowiedz się, jak rozliczać paragony, bilety autostradowe i faktury uproszczone w spójnym systemie księgowym.